2017-10-20 雷锋网

雷锋网 AI科技评论消息,北京时间10月19日凌晨,DeepMind在Nature上发表了名为Mastering the game of Go without human knowledge(不使用人类知识掌握围棋)的论文,在论文中,Deepmind展示了他们强大的新版本围棋程序“AlphaGo Zero”—— 仅经过三天训练,就能以100:0击败此前击败李世石的AlphaGo Lee,经过21天训练,就能达到击败柯洁的AlphaGo Master的水平。具体信息可参见100:0!Deepmind Nature论文揭示最强AlphaGo Zero,无需人类知识。

AlphaGo Zero的横空出世又一次引起大众争相讨论和转发,雷锋网 AI科技评论也第一时间联系到相关研究领域的教授和同学,与他们聊了聊看到AlphaGo Zero之后的一些思考和启发。

加拿大西蒙弗雷泽大学计算机学院教授、Canada Research Chair裴健第一时间对AI科技评论表达了他的观点,“最近的一系列成就把机器学习这把梯子又加长了很多,现在我们能爬很高的墙了,但这把梯子还是不能把我们带到月球。”

得到裴健教授如此评价的AlphaGo Zero究竟是什么呢?接下来,AI科技评论将会为大家带来它的相关介绍、关键技术、进行这项研究的意义以及一些更深层次的思考。

AlphaGo Zero是什么

AlphaGo Zero与原始的AlphaGo版本究竟有什么不同呢?上海交大CS系博士生李泽凡为我们带来了全面解答:

首先是网络输入的不同。在原始的AlphaGo版本中,首先用大量的人类对战棋谱进行输入训练,而AlphaGo Zero单纯地用黑子白子进行输入。

其次是网络设计的不同。AlphaGo的算法将policy网络和value网络,即策略网络和价值网络分开训练。但Alphago Zero将这两个网络联合训练,使得最后表达能力更好。并使用了残差网络模块,使得网络的深度能够得到大幅提升,表达能力更强。

另外,Alphago Zero不使用走子演算的方法对落子位置进行评价,而使用神经网络直接进行评价。

最后,在训练方法上,Alphago Zero在每一步进行自我博弈训练的时候,其对手(陪练)往往设置成跟Alphago Zero在一个水平上的。这样的渐进学习方式也是提升训练效果和效率的因素。

从与李泽凡的讨论中可以看到,相较于原始版本,AlphaGo Zero进行了诸多改进。那么,最终决定AlphaGo Zero表现和效率决定性因素具体是哪些呢?

“从论文上看,应该取决于三方面的因素。一是采用了一些改进的强化学习方法,使得学习过程收敛更稳定。二是从零开始学习,使得模型摆脱人类知识的束缚,有可能去探索更优的局部解。三是采用了最新的模型设计,如更深的残差卷积网络,使得优化、计算量和表达能力三方面都有增强。”纽约大学博士生张翔很好地解决了AI科技评论的疑问。

除了张翔,南京大学副教授俞扬博士在看到论文之后也对AI科技评论表示,

AlphaGo Zero的主要改进是在神经网络上使用了ResNet,以及在强化学习中使用了MCTS寻找学习样本标记。由于技术的改进,使得总体的MCTS可以极大简化,测试速度也因此得到了大幅提升。

另外,大部分同学认为,从0到1训练模型,抛弃人类经验,是一个相当重要的因素,也是一个值得借鉴的创新点。

“围棋经过上千年的传承,虽然不断会有新的突破,但整体上‘赢’的思维或套路可能已经趋于统一。因此,从优化的角度来看,利用人类知识进行学习的机制可能还是会让网络陷入跟人类思维一致的局部最优。但AlphaGo Zero这种从0开始的self-motivated强化学习机制,会使网络尝试各种可能性,打破基于人类知识的固化思维,从而获得更优解。”UIUC(伊利诺伊大学香槟分校) 博士后魏云超如是说道。

清华大学交叉信息研究院博士后王书浩也对AI科技评论表示,这种抛弃人类经验的方法与之前的工作相比,去除了领域知识相关的特征图像提取过程,更加接近于End-to-End的模型训练,能够达到更优的训练效果。

而在今年的ICCV上,UIUC联合培养博士沈志强发表了一篇类似观点的文章:使用预训练(人类知识或者其他大规模数据集)的模型可能会存在bias或者陷入局部极值点,往往得不到最佳的性能,而from scratch的训练(权重随机初始化)因为没有任何先验或者偏见,模型反而可以朝着正确的方向收敛,最后得到更优的性能。

实现AlphaGo Zero难吗?

可以看到,实现AlphaGo Zero算法的关键在之前也有过一些相关研究。这些关键性技术是否超乎了我们的想象范畴?

在与AI科技评论的交流中,张翔表示,这种技术对于学界来说并不新鲜。“对于围棋这样规则和目标可以精确定义的问题,自我比赛过程中通过输赢产生了足够的反馈信号,使得从零开始学习变得可能。”

王书浩则表示,当看到AlphaGo Zero,他非常惊讶。他继续说道,

不是因为这个工作复杂的可怕,而是简单的可怕。整个工作没有使用非常复杂的新算法,而仅仅用了深度强化学习和MCTS搜索,但是就是这样一个简单直接的尝试,得到了超越之前所有AlphaGo版本的“零度阿尔法狗”(AlphaGo Zero)。

虽然这些想法并没有什么非常大的创新点,但要说到具体实现,难度如何呢?

目前来说,能实现如此技术的,也非DeepMind莫属。

“虽然对于学界来说,实现方法并不会使人感到非常惊讶,但目前只有DeepMind有这样的团队,以及领先一整个工程迭代的技术,才能够做这样的研究。”张翔对AI科技评论说道。

沈志强也对AI科技评论表达了类似于张翔的观点:DeepMind团队拥有非常强的工程能力,这点毋庸置疑,他们能够把算法实现过程中的每个细节包括参数设置等都把握的很好。

AlphaGo Zero给我们带来了什么

可以看到,AlphaGo Zero在算法上做的创新并不多,但实现起来却极具技术难度。那么,DeepMind进行这项极具难度的技术研究到底会带给我们什么实际意义呢?在这一点上,大家畅所欲言。

解放人力成本:

“AlphaGo Zero代表着AI的实现不需要模仿或追寻人类智能的模式。大规模高速计算能力是机器智能的本质特征。机器也要扬长避短。封闭规则下的问题相对比较容易突破。在封闭规则下,搜索是重体力劳动。这次的成功为人类提供了新的工具。人类可以集中精力在更有创造性的智能任务上,把很多的搜索子任务交给机器完成。”裴健教授如此说道。

促进强化学习的发展:

而南京大学副教授俞扬博士对AI科技评论表示,他们在最近的一项免模型直接动作求解的研究工作中发现,求解出样本标记能够大幅提高强化学习效率,而以往方法样本利用率很低,依赖大量采样才能学好。

这次的论文中,AlphaGo Zero采用了规划的方法求解学习样本的标记,使得强化学习学得更好,这一思路也许在未来强化学习的发展上有重要作用。

有助于我们摆脱思维定势:

“AlphaGo Zero的这种学习方法以及创新突破告诉我们,应该如何考虑摆脱人类固有的思维和认知来解决一些实际问题,或者说可以考虑让计算机自己来学习解决这些问题的策略。通过算法的自我学习和探索,可能会得到人类意想不到的答案。”沈志强对AI科技评论说道。

同时,王书浩也表达了相同的观点,他表示,AlphaGo Zero教我们一定要打破思维定式,敢于从0到1。

更深层的讨论

当然,除了AlphaGo Zero给我们带来的实际意义,也要考虑到当前技术发展的局限性,以及如何带来更有应用价值的成果。

俞扬博士从应用价值的角度提出了相关思考:

DeepMind在AlphaGo Zero里没有使用人类数据和人工特征,主要是为了满足关于通用性的追求,同时也在挑战算法的能力。但是在解决应用问题时,如果能够低成本的获得人类数据,依然能够帮助强化学习系统快速取得较好的结果,这将会极具应用价值。

这次AlphaGo Zero的大热,也让加州大学伯克利分校博士生许华哲展开了对未来的思考,他对AI科技评论表示,“如何让智能算法去推理(reason)然后完成自我学习应该还有很长的路要走。那天会来,但应该还很远很远。”

总结:可以看到,AlphaGo Zero并没有用到很多创新的想法,但给我们带来了很多新的思考,对于学术研究也有其实际意义。不过,目前来讲,这种强化学习的方法想要走向实际应用,还有很长的路要走。正如裴健博士所言,虽然研究的梯子加长了,但是要想登上月球,还是远远不够。

论文地址:

https://deepmind.com/documents/119/agz_unformatted_nature.pdf

雷锋网 AI科技评论。

本文来自腾讯新闻客户端自媒体,不代表腾讯新闻的观点和立场

相关阅读:

最强AlphaGo怎样炼成?刚刚,DeepMind团队进行了全面解读

量子位

2017-10-20 06:30

安妮 李林 发自 凹非寺

昨天AlphaGo再次震惊所有人。

刚刚,这个史上最强围棋AI的两位主要开发者,David Silver和Julian Schrittwieser,做客知名网站reddit,展开一场超级问答AMA(Ask Me Anything)。

他们是谁?

△左:Julian Schrittwieser 右:David Silver

比较关注AlphaGo的朋友对其中一位应该不会陌生,David Silver是AlphaGo团队负责人,也是上一代AlphaGo的主要作者。从首尔到乌镇,都有他的身影。关于David Silver我们在之前报道黄士杰的文章里也有提及。

名字更长的Julian Schrittwieser,是这次新一代AlphaGo的三位并列主要作者之一,而且非常年轻。2013年,Schrittwieser本科毕业于奥地利的维也纳技术大学;同年9月,Schrittwieser加入DeepMind。

此前DeepMind关于AlphaGo和星际2的研究论文中,Schrittwieser也都有参与。

OK,背景交代到这里。

干货时间开始。

以下问答经过量子位(QbitAI)编辑整理。

最强AlphaGo是怎么炼成的

提问:深度强化学习本来就是出了名的不稳、容易遗忘,请问你们是如何让Zero的训练如此稳定的?

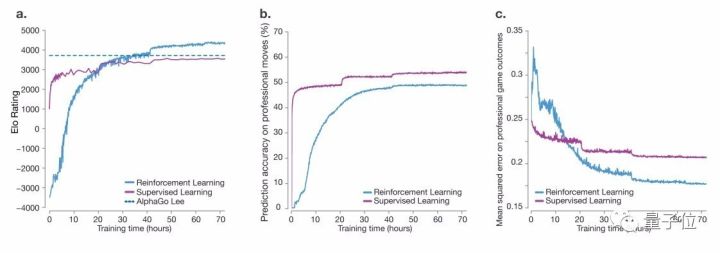

下图显示了在自我对弈强化学习期间,AlphaGo Zero的表现。整个训练过程中,没有出现震荡或者灾难性遗忘的困扰。

△引自AlphaGo Zero论文

David Silver:AlphaGo Zero所用的算法,与策略梯度、Q-learning之类的传统(无模型)算法完全不同。通过使用AlphaGo搜索,我们大大改进了策略和自我对弈结果,然后用简单的基于梯度的更新来训练下一个策略和价值网络。

这似乎比渐进的、基于梯度的策略改进要稳定得多,梯度策略可能会忘记之前的优化。

提问:为什么这次AlphaGo Zero就训练了40天?训练3个月会怎么样?

David Silver:我想这是一个人力和资源优先级的问题。如果我们训练了3个月,我想你还会好奇训练6个月会发生什么

提问:看完论文我有个疑问,输入维度那么高好像完全没必要,AlphaGo的residual block输入维度为什么是19×19×17?我不太理解为什么每个玩家要用8个二值特征plane。

David Silver:实际上,不是只有8 planes这一种选择,用其他形式的表示可能也没问题,但我们用了观察值的堆叠历史,有三个原因:

这和其他领域,比如说玩雅达利游戏时的常见输入表示一致;

我们需要一些历史记录来呈现ko;

历史可以用来记录对手最近在哪落过子,这些信息可以当作一种注意力机制来用,比如说集中在对手认为重要的位置上,第17个plane记录的是我自己在用什么颜色,因为有贴目规则,这个信息也很重要。

提问:你们发了AlphaGo论文之后,网友们说里边的算法实现起来不难,但很难达到你们那个训练量;在计算机下象棋的圈子里,开发者们也没少复制其他程序的算法。你认为算法和数据哪个更重要?

Julian Schrittwieser:我认为还是算法更重要,比较一下新AlphaGo Zero和之前论文中的版本,新版效率有多高就知道了。另外,我认为我们在数据效率方面还能有更多提升。

提问:据说和柯洁对战的AlphaGo,计算力的消耗只有对战李世乭版本的十分之一。这中间做了怎样的优化,能简单说是AlphaGo的算法比之前提高了10倍吗?

(量子位注:和柯洁对战的AlphaGo Master,用了和Zero版一样的算法和架构,不同之处在于引入了人类对局数据和特征。)

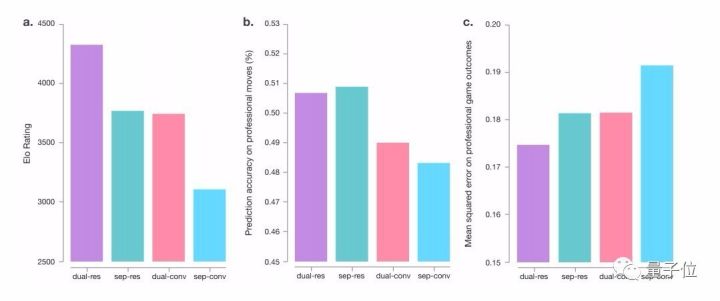

Julian Schrittwieser:主要是因为改进了价值/策略网络,训练和架构都变得更好了,不同的网络架构之间的对比如下图所示:

提问:你们为什么一开始选择用人类对局数据来训练AlphaGo,而不是通过自我对弈来从0开始?还是当时也尝试了但效果不好呢?为什么会这样?我想知道,两年前设计一个完全自学的AlphaGo瓶颈在哪?

David Silver:创造一个完全自学成才的系统,一直是强化学习中的一个开放式问题。我们一开始尝试的方法,以及在文献综述部分提到的很多其他方法,都非常不稳定。我们做了很多实验,最终发现,AlphaGo Zero的算法是最有效率的,好像攻克了这个特定的问题。

提问:为什么在刚开始训练的时候也要每局下1600步?这时候应该都是随机的噪声吧……先快速下很多盘随机局,然后在网络训练得更好的时候,再进行更深的搜索不是更好吗?

Julian Schrittwieser:一开始少下几步可能也行,但在整个试验中保持统一是一种比较简明的做法。

提问:在输入特征上,用delta featurization可行吗?

Julian Schrittwieser:神经网络实在是很擅长用不同方式来表示同样的信息,所以,是的,我认为用delta featurization应该也行。

提问:你们有没有想过用生成对抗网络(GAN)?

David Silver:在某种意义上,AlphaGo的自我对弈训练已经有了对抗:每次迭代都试图找到上一代版本的“反策略”。

△左:Julian Schrittwieser 右:David Silver

为何成功者不是Facebook

提问:我听说在AlphaGo开发初期,你们在训练中人为向特定方向引导,来解决它在棋局中表现出来的弱点。现在它的能力已经超越人类认知了,会不会还需要人工调整,避免它落入局部最大化?你们有这个打算吗?

David Silver:实际上,我们从来没有为特定的弱点而人为引导过AlphaGo,而是一直专注于原则化的机器学习算法,让算法自己学会纠正自己的错误。

想找到围棋的最优解当然是不现实的,所以,弱点总是存在。在实践中,用正确的探索方法来保证训练没有卡在局部最优解中非常重要,但我们没有用上人为的引导。

提问:AlphaGo的研究中,最困难的是什么?

David Silver:我们遇到的第一个大挑战,是在跟李世乭比赛的时候。当时我们意识到,AlphaGo偶尔会产生“妄想”,也就是会系统地误判盘面情况,并且持续数手。我们尝试了很多想法来解决这个弱点。而引入更多围棋知识,或者人类元知识一直是种诱惑。

但最终我们取得了巨大的成功,彻底解决了AlphaGo的问题。我们用的方法是,更多的依赖强化学习的力量,让它自己找到更好的解决方案。

提问:AlphaGo在行棋时间安排上是怎么考虑的?

David Silver:我们实际上用了一个相当直接的时间控制策略,基于自我博弈中胜率的简单优化。当然可以应用更复杂的策略,性能也应该可以再提升一点点。

提问:NIPS论文Thinking Fast and Slow with Deep Learning and Tree Search也提出了和AlphaGo Zero类似的方法。

论文地址:

https://arxiv.org/abs/1705.08439

David Silver:这的确和AlphaGo的策略算法很相似,不过我们还有个价值模块。以及要澄清一下,在AlphaGo Zero论文4月7日提交给Nature的时候,那篇NIPS论文还没公开。

提问:DeepMind和Facebook研究这个问题大概是在同一时间诶,是什么让AlphaGo这么拿到了围棋最高段位?

David Silver:Facebook更专注于监督学习,这是当时最厉害的项目之一。我们选择更多地关注强化学习,是因为相信它最终会超越人类的知识。最近的研究结果显示,只用监督学习的方法的表现力惊人,但强化学习绝对是超出人类水平的关键。

AlphaGo不开源,星际2还早

提问:你们有开源AlphaGo的计划吗?

David Silver:我们过去开源了不少代码,但是开源这个过程总是很复杂。在AlphaGo这个问题上,非常不好意思,它的代码库实在是过于复杂了。

提问:乌镇时说过的围棋工具什么时候发布?

David Silver:这项工作一直在推进,敬请期待

提问:AlphaGo Zero还在训练么?未来还会有突破么?

David Silver:AlphaGo已经退役了!我们的人力和硬件资源,已经动身前往其他道阻且长的AI项目上了。

提问:AlphaGo Zero是最终版本的AlphaGo么?

David Silver:我们已经不再主动研究如何让AlphaGo变得更强,但它仍然是所有DeepMind同仁的研究测试平台,用于尝试新的想法和算法。

提问:与围棋相比,《星际2》有多难?AI打星际什时候能有新进展?

David Silver:前不久我们刚发布了《星际2》的环境,现在相关研究还在相当早期的阶段。《星际2》的行为空间显然比围棋大得多,需要监控的数据量也更大。从技术上来讲,围棋是一个完美信息博弈,而战争迷雾让星际变成不完美信息博弈。

关于AI研究

提问:AlphaGo在神经网络的可解释性方面有什么进展?

David Silver:可解释性对我们所有的系统来说都是有趣的问题,而不仅仅是AlphaGo。DeepMind内部正努力研究询问系统的新方式。最近,他们的研究已经发表出来,主要是从认知心理学出发,来尝试破译神经网络内部的情况。这项研究非常棒。

量子位插播一个延伸阅读:

DeepMind新论文:用认知心理学方法打开深度学习的黑箱

提问:似乎使用或模拟强化学习智能体的长期记忆是一个很大瓶颈。展望未来,你是否相信我们即将以一种新的思维方式“解决”这个问题?

Julian Schrittwieser:你说的没错,长期记忆确实是个重要因素。例如,在星际争霸的一场比赛中可能有上万个动作,另外还得记住你侦察到的东西。

我认为目前已经有了很一颗赛艇的组件,比如神经图灵机,但在这个领域,我们还将看到一些更令人印象深刻的进步。

提问:有没有强化学习(RL)用在金融领域的案例?

David Silver:很难在公开发表的论文中找到真实世界的金融算法!但是有一些经典论文非常值得一读,例如Nevmyvaka和Kearns在2006年发布的研究、Moody和Safell在2001发布的研究。

提问:不读研也能在人工智能领域大有作为吗?

Julian Schrittwieser:当然可以,我也只有计算机科学学士学位。这个领域发展很快,所以我认为你可以从阅读论文和运行实验中学习很多东西。在已经有过机器学习经验的公司实习是对你的成长应该很有帮助。

提问:怎样进入AI行业?我觉得“读个PhD然后找工作”好像是个挺明显的途径,但是最常见的路径不见得就是最好的吧……

Julian Schrittwieser:还有一种方法效果也不错:挑一个有意思的问题,训练很多神经网络,探索它们的结构,然后你会发现一些效果很好的部分,去发表一篇论文,或者去参加会议展示你的成果。

不断地重复这个过程。

这个圈子很好,会愿意给你反馈,你也可以通过arXiv了解最近的研究。

关于围棋

提问:现在国际象棋程序能给选手评分:通过棋步的分析,来推算Elo等级分。AlphaGo能在围棋上搞这个吗?

相关论文:

https://www.cse.buffalo.edu/~regan/papers/pdf/ReHa11c.pdf

Julian Schrittwieser:这个想法很酷啊,感谢分享这篇论文!

我认为在围棋上也能做这样的事情,可能会通过计算最佳下法和实际下法之间的价值差异来实现,或者计算策略网络下出实际下法的概率。等我有时间试试这个。

提问:关于对局中的第一手棋,我想问,AlphaGo会有一些你从未见过的开局吗,比如10-10或5-3,或者走很奇怪的一步?如果没有这种情况,那是出于“习惯”,还是有强烈的信念,3-3、3-4和4-4是优越的?

David Silver:在训练中,我们看到AlphaGo探索了各种不同的动作——甚至在训练开始时下出过1-1!即使在经过一段训练后,Zero也尝试过下6-4,但很快又回到了熟悉的3-4。

Julian Schrittwieser:实际上,在刚开始训练AlphaGo Zero时,它完全是随机的,例如在图5的b部分中,你可以看到它实际上是在1-1点下出第一手!逐渐适应网络后,随着它变得更强大,它开始青睐4-4、3-4和3-3。

提问:现在AlphaGo能让顶级围棋选手几子?能让柯洁两子么?

David Silver:我们还没跟人类选手下过让子棋,我们想专注在整场的围棋比赛中。然而,在让子条件下测试不同版本的AlphaGo很有用。在Zero的论文中我们提到了各个版本的棋力:AlphaGo Master > AlphaGo Lee > AlphaGo Fan,每个版本都让三子击败了它的前一代。

值得注意的是,因为这些神经网络没有专门为让子棋训练过。此外,由于AlphaGo是自我对弈训练的,特别擅长打败自身较弱的版本。因此,我认为我们不能以任何有意义的方式将这些结果推广到人类的让子棋中。

提问:AlphaGo Zero会处理征子之类的问题吗?你们是怎样解决这类问题的?

David Silver:AlphaGo Zero并没有特殊的特征来处理征子,或者任何其他围棋中的特定问题。在训练早期,Zero偶尔会因为征子下满棋盘,就算它对全局有很复杂的理解也没用。但在我们分析的棋局中,经过完全训练的Zero能正确识别所有无意义的征子。

提问:已经发布的少量AlphaGo自我对弈棋局中,白棋胜率太高。是不是贴目应该降低?

Julian Schrittwieser:从我的经验和实验来看,贴7.5目非常平衡。我们只观察到白棋的胜率略高一点(55%)。

提问:你们认为AlphaGo能解《发阳论》第120题吗?(传说中的“死活题最高杰作”)

David Silver:我们刚才去问了樊麾,他说AlphaGo能解这个问题,但更有意思的是,它会不会找到跟书里一样的答案?还是能给出一个之前谁也没想到的解法?在AlphaGo的很多对局中,我们都看到了以人类经验无法想象的下法。

提问:迈克·雷蒙(Michael Redmond,首位非东亚裔围棋九段)认为AlphaGo会下出人类棋手不会有的恶手,而且学不会围棋定式(深度程序知识)。

David Silver:我相信AlphaGo的“恶手”只有在影响全局胜利时才是问题。如果结局仍然是稳赢,真的是很差的一招么?

AlphaGo已经学会很多人类的定式,也下出了自己的定式。现在职业棋手有时就在使用AlphaGo的定式

提问:1846年,桑原秀策四段对弈幻庵因硕八段,其中著名的是第127手。AlphaGo怎么看这手棋?AlphaGo会怎么下?

Julian Schrittwieser:我不是围棋专家,但是我们问了樊麾,他说:

当年比赛的时候,还没有贴目这一说。现在,AlphaGo采用的都是贴7.5目的规则。贴目让对弈过程完全改变。至于第127手,AlphaGo很有可能会选择不同的下法。

提问:还会再和职业棋手下棋吗?

Julian Schrittwieser:我们五月份说过,乌镇那场就是AlphaGo的最后一次比赛了。

— 完 —

声明:本文由入驻搜狐号的作者撰写,除搜狐官方账号外,观点仅代表作者本人,不代表搜狐立场。

不懂卷积神经网络?别怕,看完这几张萌图你就明白了

量子位

2017-10-20 06:30

林鳞 编译自 authomaton.blogspot

这篇文章用最简明易懂的方式解释了卷积神经网络(CNN)的基本原理,并绕开了里面的数学理论。

同时,如果想对从头开始构建CNN网络之类的问题感兴趣,作者推荐去读《 Artificial Intelligence for Humans Volume 3: Deep Learning and Neural Networks》中第10章节的内容。

不多说了,开始CNN之旅——

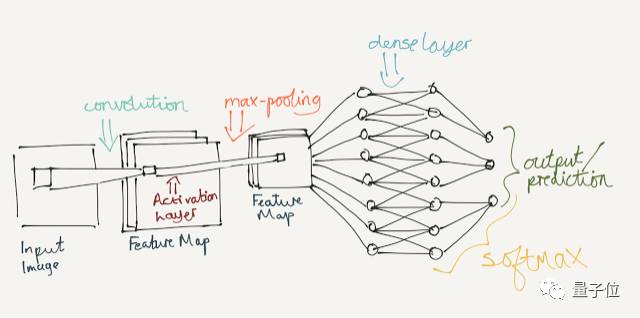

网络结构

CNN的模型通常建立在前馈神经网络模型之上,它的结构你也应该不陌生。不同是的,“隐藏层”将被以下这些层取代:

卷积层(Convolutional Layers)

池化层(Pooling Layers)

全连接层(稠密层,Dense Layers)

结构类似下图:

卷积

在此阶段,输入图像被一个grid扫描,并作为输入传递到网络。之后,这个网络将一层卷积层应用于输入的图像,将它分割成包含3张图像的三维立方体结构。这3三张图像个框架分别呈现原图的红色、绿色和蓝色信息。

随后,它将卷积滤波器(也称神经元)应用到图像中,和用PhotoShop中的滤镜突出某些特征相似。例如在动画片《Doc And Mharti》中,用罗伯茨交叉边缘增强滤波器处理过的效果如下图所示:

△原图

△处理后

可以想象,拥有100多个不同滤波器的神经网络筛选复杂特征的能力有多强大,这将大大助力它识别现实世界中事物。一旦神经网络已经将卷积滤波器应用到图像中,我们就能得到特征/激活图。

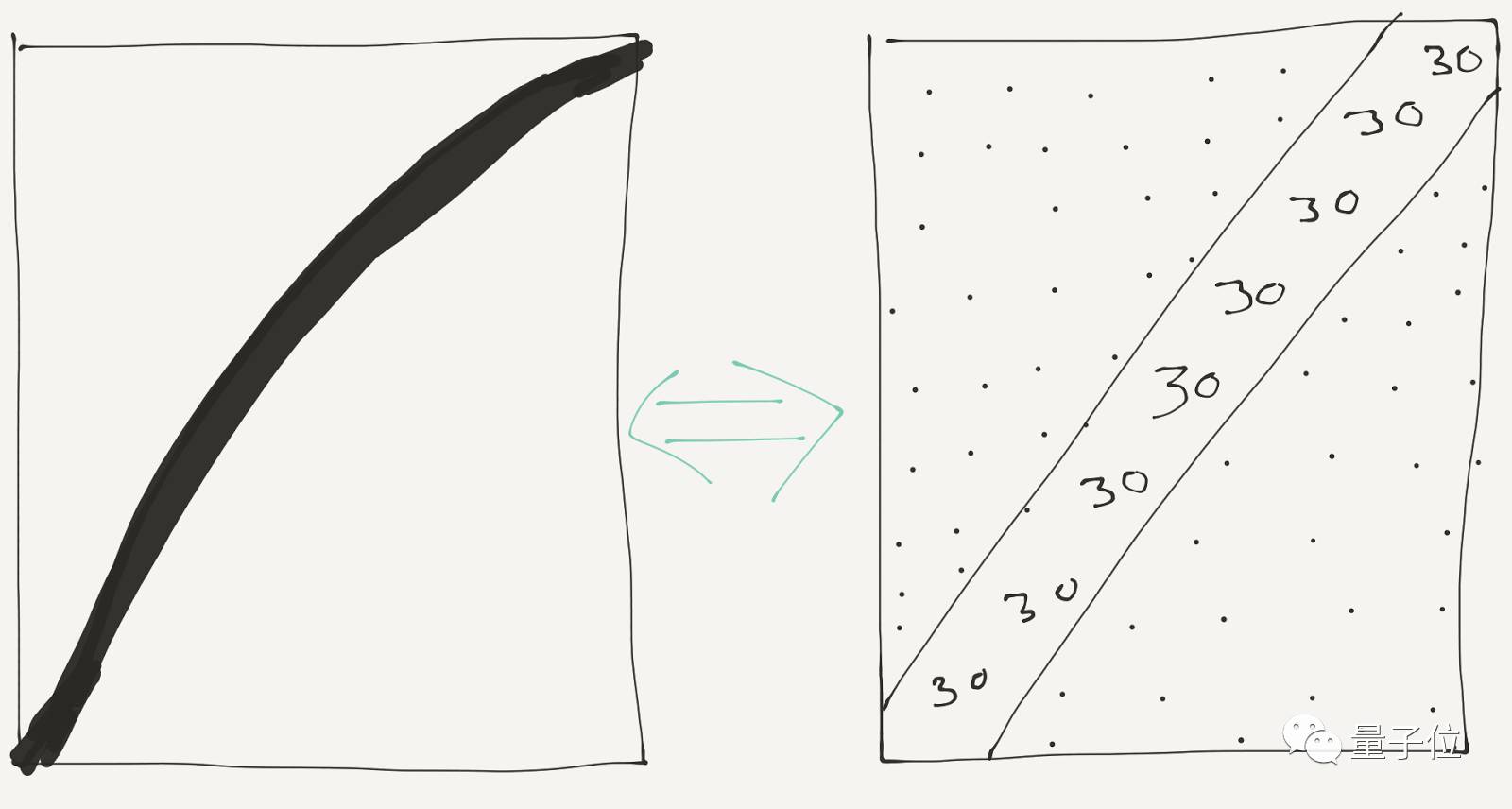

特征图谱会被指定区域内的特定神经元激活,比如我们将边缘检测滤波器添加到下面左图中,则它的激活图如右图所示:

△这些点代表0的行(表明这些区域可能是边缘)。在二维数组中,“30”的值表明图像区域存在边缘的可能性很高 激活层

当我们有了激活图,就能在其中让激活函数大显身手了,我们用研究人员的首选函数——ReLU激活函数(修正线性单元)举个例子。然而,一些研究人员仍然认为用Sigmoid函数或双曲切线能得到提供最佳的训练结果,但我不这么认为。

使用激活层是在系统中引入非线性,这样可以提高输入和输出的一般性。ReLU(x)函数只返回max(0、x)或简单地返回激活图中的负权值。

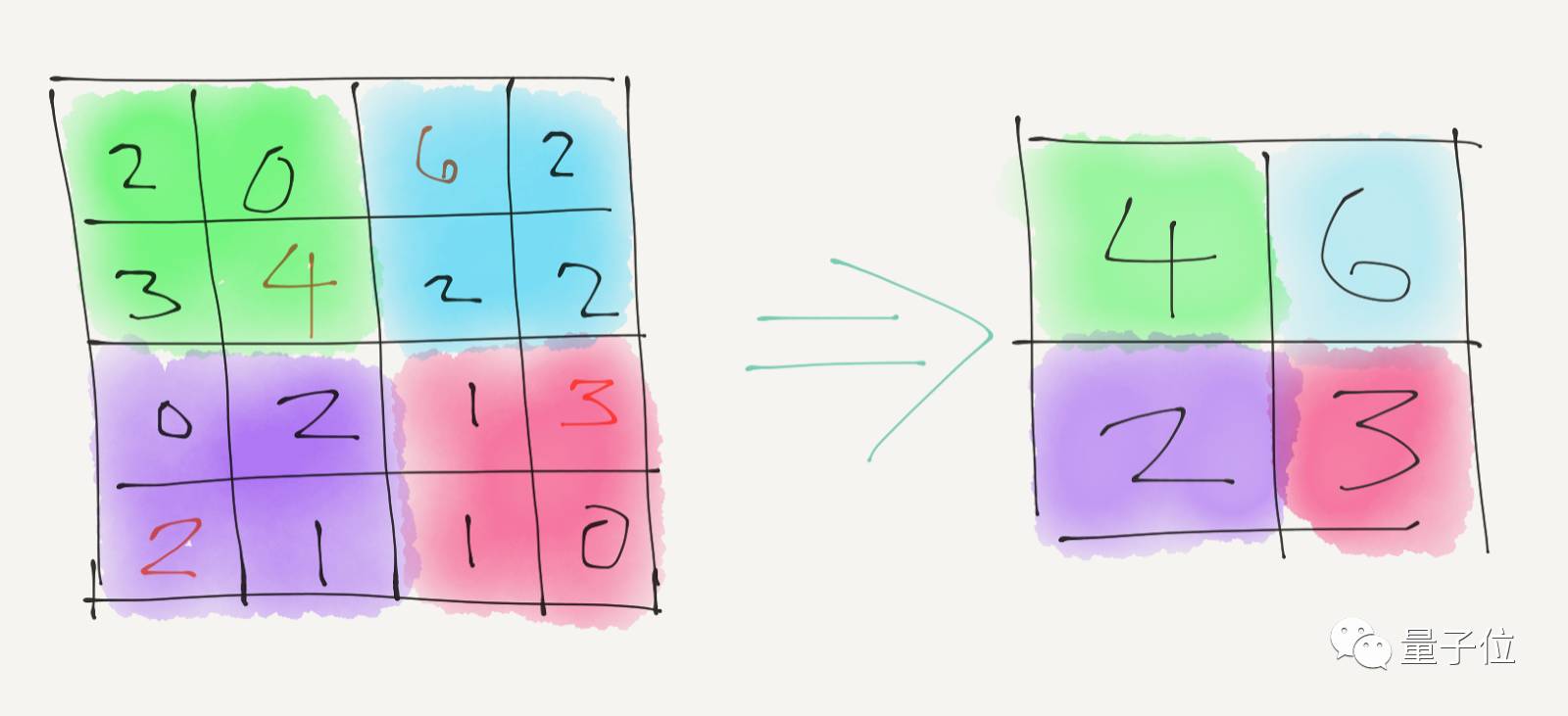

池化层

之后的最佳做法通常是在特征图中应用最大池化(或任何其他类型的池)。应用最大池化层的原理是扫描小型grid中的图像,用一个包含给定grid中最高值的单个单元替换每个grid:

这样做的重要原因之一是,一旦我们知道给定特征在一个给定的输入区域,我们可以忽略特征的确切位置将数据普遍化,减少过拟合。举个例子,即使训练精度达到99%,但拿到没见过的新数据上测试时,它的精确度也只有50%。

输出层

最大池化层后我们讲讲剩下的另一个激活图,这是传递给全连接网络的一部分信息。它包含一个全连接层,将上一层中每个神经元的输出简单映射到全连接层的一个神经元上,并将softmax函数应用到输出中,就是和我们之前提到的ReLU函数类似的激活函数。

因为我们将用神经网络将图片分类,因此这里使用了softmax函数。softmax输出返回列表的概率求和为1,每个概率代表给定图像属于特定输出类的概率。但后来涉及到图像预测和修复任务时,线性激活函数的效果就比较好了。

值得注意的是,讲到这里我们只考虑了单卷积层和单池层的简单情况,如果要实现最佳精度通常需要它们多层堆叠。经过每个完整的迭代后,通过网络反向根据计算损失更新权重。

原文地址:

https://authomaton.blogspot.co.u ... -but-funner-02.html

— 完 —

声明:本文由入驻搜狐号的作者撰写,除搜狐官方账号外,观点仅代表作者本人,不代表搜狐立场。

[

本帖最后由 druid169 于 2017-10-20 12:56 编辑 ]

![SiS001! Board - [第一会所 关闭注册]](images/green001/logo.png)